Small language model 최강자를 가리자 - EXAONE3.5의 선전!

EXAONE3.5, Qwen2.5, Phi3.5, Gemma2 등 최대 3B 파라미터를 가지는 소형 언어 모델들의 수능 영어 성적을 직접 벤치마크해봅니다. 과연 어떤 모델이 소형 언어 모델 최강자 자리를 차지했을까요?

AI 기술의 발전 속도가 가파르게 진행되면서, OpenAI-o3를 필두로 한 대형 언어 모델(Large Language Model, LLM)의 성능은 거의 인공일반지능(Artificial general intelligence; AGI)에 근접하고 있습니다. 하지만, 이러한 모델들은 비용적, 경제적인 한계에 의해 당분간 과학 연구 등 굉장히 복잡하고 깊은 사고를 요하는 문제 해결에 주로 사용될 것으로 보이고, 우리의 일상에 이런 초고성능 모델이 널리 활용되는 것은 아직도 먼 미래라는 생각이 듭니다.

이에 따라 온디바이스(on-device) AI 모델 관점에서, 모델의 크기(파라미터 수)를 늘리지 않으면서, 높은 성능을 보이는 모델인 소형 언어 모델(Small Language Model, SLM) 개발의 중요성도 부각되고 있습니다. 특히 애플은 온디바이스 AI를 위해 개별 task에 특화된 소형 언어 모델을 각각 만들어 활용하는 전략을 취하고 있는 것으로 유명한데요, 작년 중순 애플이 공개한 OpenELM (Open-source Efficient Language Models)이라 하는 모델 패밀리를 통해 어떻게 비교적 적은 파라미터로도 좋은 성능 효율을 내는지 약간은 힌트를 얻을 수도 있을 것 같습니다.

그렇다면 과연 2025년 지금, 오픈소스 소형 언어 모델은 어디까지 왔을까요? 이를 알아보기 위해, 다양한 오픈소스 소형 언어 모델을 대상으로 포괄적인 벤치마크를 직접 진행해 보았습니다. 그 결과를 공개합니다!

수능 영어 벤치마크

아래 포스팅에서는 로컬 환경에서 다양한 언어모델의 성능을 제 입맛에 맞게 확인해볼 수 있게, 2023, 2024, 2025학년도 3개년도 문제들로 구성된 자체 수능 영어 벤치마크를 구성해보았습니다. 이번 소형 언어 모델 벤치마크에서도 같은 방식으로 벤치마크를 진행해 보겠습니다. 벤치마크 셋 구성에 대한 자세한 내용은 아래의 두 포스팅을 참고해주세요!

모델 선정

비교 대상이 될 소형 언어 모델들은 어떤 것들을 선정하면 좋을까요? 바람직하게도, 소형 언어모델의 개발은 오픈소스 중심으로 이루어지고 있는 것 같습니다. 모델 크기가 작아 비교적 쉽고 빠르게 모델을 학습하고 성능 확인도 해볼 수 있다보니, 연구개발 측면에서는 대형 언어모델보다 소형 언어모델 쪽의 접근성이 더 좋아 보이네요.

여기서는 ollama에 공개된 대표적인 ~3B 파라미터 모델들 8종을 모아 벤치마크를 해보겠습니다. 각각의 모델에 대한 설명은 아래를 참고해 주세요.

| 모델:파라미터 수 | 개발 주체 | 간단 설명 |

|---|---|---|

| EXAONE3.5:2.4b | LG AI Research | LG AI 연구원에서 개발한 instruction-tuning된 2개국어(영어 & 한국어) 모델 (24년 12월) |

| Qwen2.5:3b | Alibaba (Qwen Team) | 알리바바 그룹(Alibaba Group)의 AI 연구팀인 Qwen에서 개발 (24년 9월) |

| smallthinker:3b | PowerInfer | Qwen2.5:3b 모델에서 fine-tuning된 “thinking” 모델 (25년 1월) |

| Phi-3.5:3.8b | Microsoft | “소형 언어 모델”을 표방하며 24년 8월 공개된 모델. 128K 토큰의 긴 문맥 처리와 다국어 지원이 강점. MIT 라이선스. |

| gemma:2b | 노트북, 데스크톱 등 리소스가 제한된 환경에서도 구동할 수 있도록 설계된 모델. Gemini 모델을 만드는 데 사용된 연구와 기술이 기반이 됨. (2024년 2월) | |

| gemma2:2b | 노트북, 데스크톱 등 리소스가 제한된 환경에서도 구동할 수 있도록 설계된 모델. Gemini 모델을 만드는 데 사용된 연구와 기술이 기반이 됨. (2024년 7월) | |

| falcon3:3b | Technology Innovation Institute (TII) | UAE의 TII에서 개발한 고성능 소형 언어 모델로, 과학, 수학, 코드 생성 등 다양한 분야에서 뛰어난 성능을 보임. (2024년 12월) |

| llama3.2:3.2b | Meta | 이전 버전인 Llama 3.1을 기반으로 성능과 기능을 크게 향상. 영어, 독일어, 프랑스어, 이탈리아어, 포르투갈어, 힌디어, 스페인어, 태국어 8개 언어 공식 지원. (2024년 9월) |

결과

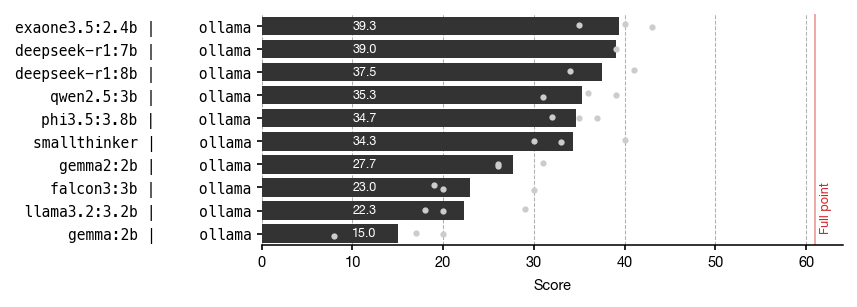

결과는... LG AI연구원의 EXAONE3.5 모델이 39.3점으로 1위를 차지했습니다 🎉 2위는 35.3점의 Qwen2.5 모델이, 그리고 3위는 34.7점으로 Microsoft의 Phi-3.5 모델이 차지했습니다.

EXAONE3.5 모델의 단점이라면, 상업적 사용이 불가능한 라이센스라는 점이 되겠습니다. 그래도 연구 목적과 개인 목적의 사용이라면 충분히 잘 활용해볼 수 있겠다는 생각이 드네요!

마치며

이번 포스팅에서는 3B 정도 되는 소형 언어모델들의 성능을 벤치마크해보았습니다. 전체적인 성능이 아직까지는 만족스럽지 않은 수준이라, 복잡한 AI 어플리케이션에 활용될만큼 충분한 신뢰도를 주고 있지는 않은 모습입니다.

![[Python] trafilatura 라이브러리로 크롤링 쉽게 하기](https://images.unsplash.com/photo-1470334165954-365e14d84faa?crop=entropy&cs=tinysrgb&fit=max&fm=jpg&ixid=M3wxMTc3M3wwfDF8c2VhcmNofDV8fHBlbGljYW5zJTIwfGVufDB8fHx8MTczNzE4MDg0MXww&ixlib=rb-4.0.3&q=80&w=960)